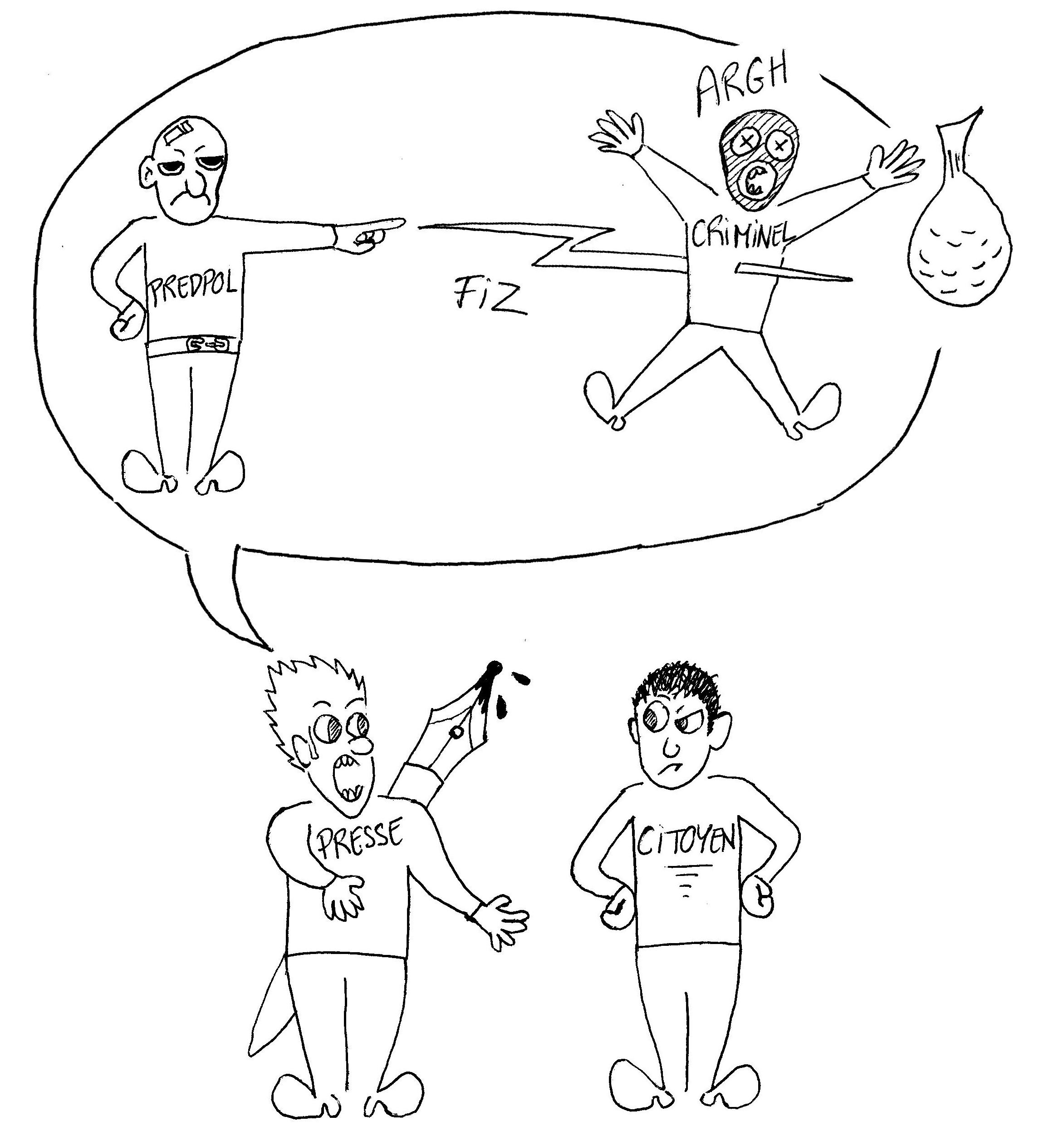

La police prédictive apparaît rapidement comme une méthode quasi surnaturelle qui surveillerait nos faits et gestes, image relayée largement par les médias. Par conséquence les citoyens craignent en partie de voir leur vie privée bafouée, de se faire arrêter par la police seulement sur la base d'une prédiction d'une machine, etc.

Cette peur se manifeste notamment dans les divers articles de presse qui traitent du sujet. Les journalistes associent souvent l'image de la police prédictive à celle produite par de nombreuses œuvres de science-fiction, dont le très célèbre film Minority Report de Steven Spielberg, adapté d'une œuvre de Philip K. Dick ("Des algorithmes, capables de « prédire » les crimes, un peu comme dans le film de Spielberg" est l'introduction d'un article paru dans Les Echos (Henno, 2015)). La comparaison n'a rien de flatteuse, mais pour la plupart des experts du sujet, comme Bilel Benbouzid, elle n'a aussi rien à voir. De même, Lyria Benett Moses et Janet Chan, du UNSW Australia and Data to Decisions Cooperative Research Centre à Sydney pensent que les médias en font un peu trop en ce qui concerne les possibilités offertes par la police prédictive (Moses & Chan, 2016). Cependant cette idée que l'on octroie à la police un outil capable de prédire sans détour le futur fait son bout de chemin, et les populations craignent à juste titre qu'un tel organisme puisse détenir à travers cette technologie une puissance inouïe.

Des mouvements citoyens vont donc se mettre en place pour critiquer le début de développement de la police prédictive en France, de même que outre atlantique de multiples associations soulèvent les problèmes d'ordre éthique de l'utilisation des algorithmes type Predpol. Le collectif bordelais Clap 33 (association visant à lutter contre les violences policières) signifie son mécontentement en relayant par exemple sur leur blog un article de Bilel Benbouzid interprété comme étant critique vis à vis de Predpol. Pourtant d'un autre côté d'autres citoyens sont persuadés de la pertinence de l’utilisation de la police prédictive et se chargent de critiquer le travail de diabolisation de cette technologie entrepris par différents journalistes. C'est notamment le cas de l'Institut pour la justice qui dans son blog répond à l'article d'un journaliste du monde (“police prédictive Archives,” n.d.).

Cette réticence populaire s'est aussi exprimée dans le cadre du projet Teralab, ancien projet de l'institut Mines-Telecom lancé par Stephan Clémençon, dont le but était de développer un algorithme de type police prédictive. Suite à un article de Mediapart (Hourdeaux, 2015) plutôt critique envers cette initiative, la gendarmerie nationale décida de se retirer du projet, qui faute de destinataire fut annulé. Pour Stephan Clémençon, que nous avons pu interroger à ce sujet, ceci est notamment dû au manque de culture scientifique de la plupart des personnes et des journalistes, qui n'ont pas cerné la véritable finalité de la police prédictive. La culture déterministe étant prédominante en ce monde, les gens n'envisagent pas la réalité statistique et attendent d'une prédiction qu'elle soit vraie ou fausse, et non juste envisageable. Le chercheur n'a jamais eu la prétention de brosser un tableau du futur sans erreur, juste de donner une idée de la répartition du crime dans le temps et l'espace à travers l'analyse des big data, sans jamais utiliser de données personnelles.

Ainsi, la police prédictive divise les différentes catégories de la population, de par son côté effrayant par bien des aspects, mais aussi par le flou qui encadre ses objectifs réels et sa manière de fonctionner. Certains craignent pour leur vie privée, tandis que d'autres envisagent les apports bénéfiques d'une telle technique, notamment en terme de sécurité.

Une des plus grandes craintes lorsque l'on commence à toucher aux big data et autres technologies d'analyse de ces données est de tomber dans les travers d'une société autoritaire qui prend pour excuse la sécurité de ses citoyens afin de les exposer à une surveillance continue, bafouant ainsi plusieurs droits fondamentaux humain.

Plusieurs ONG adressent ce genre de reproche à des sociétés de surveillance comme Palantir aux Etats-Unis, société notamment aussi connue en France pour être un prestataire des services spéciaux français. Pour certains, comme Edin Omanovic, spécialiste des technologies de surveillance pour l'ONG Privacy International, Palantir profite malhonnêtement du renforcement de la sécurité décidé par les gouvernements pour violer la vie privée des individus. Chris Hoofnagle, professeur de droit à l'université de Berkeley et membre du Palantir Council of Advisors on Privacy and Civil Liberties (PCAP), assure cependant que les algorithmes utilisés par Palantir respectent dans leur conception les libertés de chacun (Tesquet, 2017).

Plusieurs spécialistes s'accordent en outre sur le fait que l'utilisation massive des big data et des logiciels de police prédictive entraîne un non-respect de la vie privée des individus et une perte de leur dignité. Carrie B. Sanders, criminologue, pense en effet que cette utilisation du 'Big data' provenant de la morale de l'économie néo-libérale où l'on veut tout prévoir, tout calculer, est faite au détriment de la dignité humaine, même si elle reconnaît la neutralité apparente des algorithmes de police prédictive (Sanders & Shepticky, 2015). Kevin Miller, employé au cabinet juridique de propriété intellectuelle Saliwanchik, Lloyd & Eisenschenk à Gainesville, estime quant à lui que l'utilisation de technologies de police prédictive pourrait violer le quatrième amendement en permettant des fouilles basées sur des éléments ne relevant pas de l'individu lui-même mais de son environnement. Il ajoute aussi que les logiciels de « profiling », qui récoltent massivement des informations sur des personnes suspectes, ne respectent absolument pas leurs libertés et sont susceptibles de changer leurs comportements (Miller, 2014). En outre, l'utilisation d'algorithmes de police prédictive pourrait conduire à la stigmatisation des criminels sortant de prison (Schlehahn et al., 2015).

Ces dérives cependant proviennent pour les spécialistes du manque de législation sur le sujet. Pour Kevin Miller notamment qui croit en l'utilité de la police prédictive mais qui appelle à une législation urgente sur l'utilisation de ces algorithmes. Jesse Hirsh, chercheur, pense aussi que le sujet n'est pas assez encadré par la loi et établit un parallèle entre les agents qui sur le terrain n'ont pas le droit d'agir en secret et les algorithmes qui devraient être soumis aux mêmes restrictions (Hirsh, 2016).

Ainsi pour beaucoup ces algorithmes ne respectent pas encore complètement les libertés des citoyens. La nature des algorithmes et de leur production n'étant pas encore complètement identifiée dans le cadre de la loi, il apparaît difficile de légiférer dessus afin d'encadrer le processus, ce qui peut conduire à des conséquences dénoncées par les associations citoyennes.

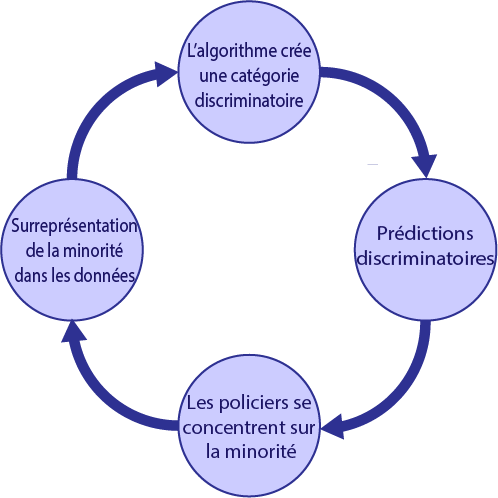

En dehors de cette tendance à s'immiscer dans la vie privée des individus et à restreindre leur liberté, les algorithmes sont critiqués par certaines associations pour reproduire apparemment un comportement raciste, ce que n'est pas sensée faire une machine a priori neutre. Aux États-Unis notamment différents acteurs, comme l'association The Leadership Conference on Civil and Human Rights, se sont rassemblés afin de signer une charte dénonçant les biais discriminatoire des logiciels de police prédictive (“Civil Rights and Tech Advocates Sound Alarm on Racial Bias in ‘Predictive Policing,’” 2016).

En premier lieu, associations et spécialistes craignent que les données utilisées en entrée par les algorithmes introduisent des biais racistes : si les contrôles d'identité et autres actions policières sont déjà fortement influencés par des caractéristiques raciales, alors lorsque ces données seront lues par les logiciels de police prédictive, ceux-ci risquent de répéter ces comportements discriminatoires dans leurs modèles. De leur côté, les concepteurs de tels logiciels pensent qu'il n'y aucun biais car les données ne sont en aucun cas personnelles (Jadoul, 2015). Mais cet argument ne convainc pas tous les spécialistes. Certains mettent en avant des biais dans la collecte des données comme par exemple profilage racial, contrôles de sécurité dans les aéroports en corrélation avec l’ethnicité (Calders & Žliobaitė, 2013). Ces données étant collectées sous des critères objectifs mais aussi subjectifs, si les modèles ne prennent pas cela en compte, cela risque fortement d'introduire des biais discriminatoires dans les résultats. D'autres soulèvent que certaines techniques du big data comme le « profiling » peuvent rapidement s'apparenter à de la discrimination raciale (Hirsh, 2016).

Une partie des acteurs préfèrent s’intéresser au cas de discrimination géographique, comme Bilel Benbouzid. En effet, pour lui, certaines aires géographiques vont être complètement exclues des algorithmes (Polloni, 2015), car les populations qui les occupent auront une propension moindre à porter plainte (pour cause de pauvreté, défiance envers les pouvoirs publics, culture de l’omerta ou de la vengeance personnelle…). Les algorithmes qui vont alors traiter ces données vont désigner ces quartiers comme peu soumis à l'insécurité, alors que justement les populations qui y vivent sont celles auxquelles la sécurité fait le plus défaut.

Ainsi les critiques adressées aux logiciels de police prédictive portent surtout sur les données qu'ils utilisent en entrée. Si ces données n'ont rien de personnelles, elles peuvent être cependant biaisées par les jugements de ceux qui les ont collectées.

Chapitre suivant : Des algorithmes de prédiction du crime améliorent-ils l’action policière ?